Triton Inference Server로 모델 서빙 성능 끌어올리기

Triton Inference Server로 모델 서빙 성능 끌어올리기

개요

- 딥 러닝 기술이 발전함에 따라 AI 모델의 성능은 향상되고 있음

- 모델의 경량화는 AI 서비스 운영을 위해서 필수적인 요소

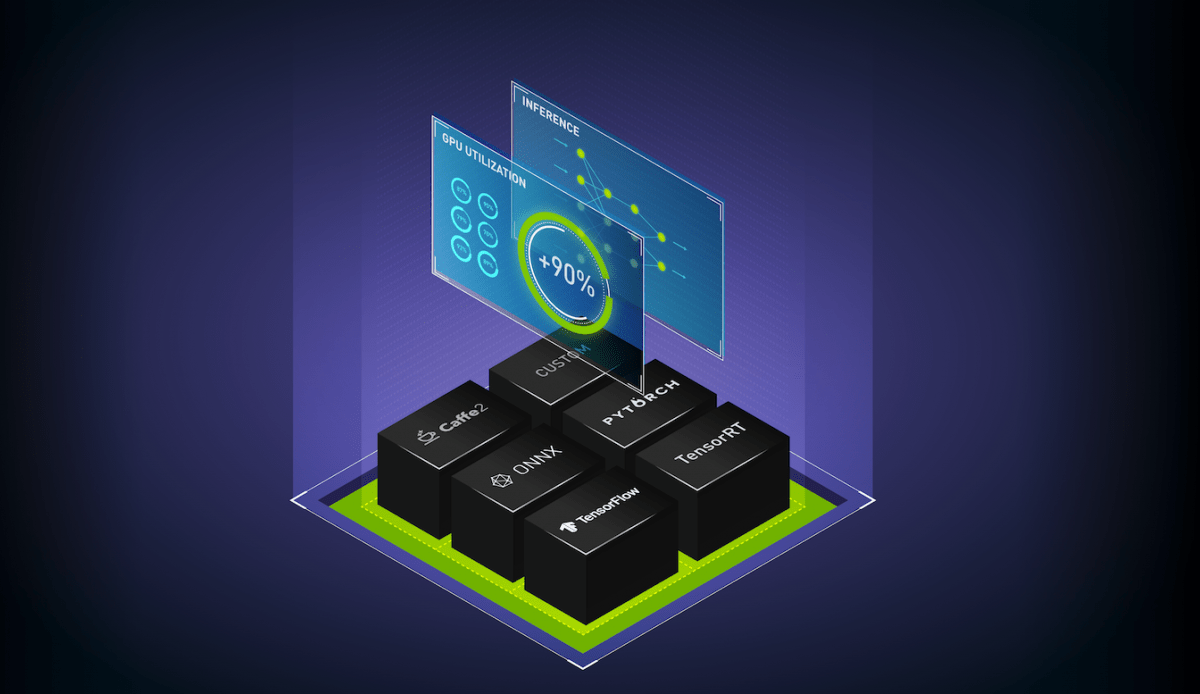

- Triton Inference Server를 이용하면 모델을 쉽게 경량화하고 배포 가능

- Triton Inference Server의 주요 장점: 다양한 모델 프레임워크 지원, 고성능 추론, 확장과 모니터링 지원, 모델 앙상블, 모델 버전 관리 등

성능 비교

- CIFAR-10 이미지를 이용해서 PyTorch로 VGG16 모델을 학습하고, ONNX와 TensorRT로 각각 변환한 뒤 모델의 메모리 사용량과 처리량을 비교

- 메모리 사용량 비교 결과: 기존 PyTorch 모델과 비교했을 때, ONNX는 메모리를 더 많이 사용하고 있으나, TensorRT는 절반도 안 되는 메모리 사용

- 처리량 비교 결과: ONNX는 Concurrency가 높아 질수록 PyTorch보다 약간 더 높아지지만, TensorRT는 처리량이 약 2배 이상 높음

결론

- 모델의 자원 사용량과 처리량 최적화가 AI 서비스 성공의 핵심적인 부분

- Triton Inference Server를 활용하여 효율적인 배포 및 성능 끌어올리기 가능